مقدمه

در کمتر از دو دهه، هوش مصنوعی (Artificial Intelligence) از پروژهای دانشگاهی به نیرویی فراگیر تبدیل شد که امروز تصمیمگیریهای ما را شکل میدهد، از مسیریابی در تلفن همراه تا تأیید وام بانکی و حتی تشخیص بیماریها. اما همانقدر که این فناوری وعده کارایی، سرعت و هوشمندی داده، همانقدر نیز نگرانیهای عمیقی درباره عدالت، شفافیت و کرامت انسانی برانگیخته است.

در جهانی که الگوریتمها بیش از انسانها تصمیم میگیرند، پرسش اصلی دیگر «چگونه کار میکند» نیست، بلکه «چگونه باید رفتار کند» است. اخلاق در هوش مصنوعی بهدنبال یافتن پاسخی برای همین پرسش است — تلاشی برای آنکه فناوری نهتنها هوشمند، بلکه انسانیتر شود.

هوش مصنوعی امروز دیگر ابزار نیست؛ بستری است که بر اساس داده، درباره آینده ما قضاوت میکند. از فیلترهای چهره تا الگوریتمهای نظارتی و از تحلیل رزومه تا توصیه پزشکی، همهجا رد پای تصمیمات ماشینی دیده میشود. با این حال، کمتر کسی میپرسد: آیا این تصمیمها عادلانهاند؟ چه کسی مسئول پیامدهای اشتباه آنهاست؟ و چه زمانی باید جلوی پیشرفت بدون مرز آن را گرفت؟

این مقاله، با نگاهی تحلیلی و استناد به منابع معتبر جهانی (IEEE, UNESCO, OECD, EU, IBM, Stanford HAI)، به بررسی بایدها و نبایدهای اخلاق در هوش مصنوعی میپردازد و میکوشد نشان دهد که چگونه میتوان بین نوآوری فناورانه و مسئولیت انسانی تعادل برقرار کرد.

تعریف اخلاق در هوش مصنوعی

اخلاق در هوش مصنوعی (AI Ethics) شاخهای میانرشتهای از فلسفه فناوری، علوم داده و سیاست عمومی است که به مطالعه نحوه طراحی، توسعه و استفاده مسئولانه از سامانههای هوشمند میپردازد . (Mittelstadt, 2019)هدف اصلی این حوزه، ایجاد تعادل میان کارایی الگوریتمی و ارزشهای انسانی است — اینکه فناوری بتواند «درست» عمل کند، نه فقط «بهدرستی کار کند».

به بیان دیگر، اخلاق در AI همان چیزی است که مرز میان «میتوانیم» و «باید» را ترسیم میکند. اگر یادگیری ماشین (Machine Learning) و یادگیری عمیق (Deep Learning) مغز AI باشند، اخلاق آن روح آن است.

در دیدگاه IBM (2023)، هوش مصنوعی اخلاقی سیستمی است که «قابل اعتماد، شفاف، و منطبق بر ارزشهای انسانی» باشد. دانشگاه استنفورد نیز در گزارش سال ۲۰۲۴ خود، اخلاق AI را «مجموعهای از اصول برای طراحی سیستمهایی» میداند که بتوانند در کنار انسان و نه بهجای او کار کنند (Stanford HAI, 2024).

چارچوب نظری: سه سطح از اخلاق در AI

اخلاق در هوش مصنوعی معمولاً در سه سطح مورد بحث قرار میگیرد:

| مثال عملی | تعریف | سطح |

|---|---|---|

| آموزش اخلاقی مهندسان داده در شرکتها | مسئولیت تصمیمات توسعهدهندگان، پژوهشگران و کاربران | فردی (Individual Ethics) |

| منشور اخلاقی Google و IBM برای AI | سیاستها و تعهدات شرکتها و نهادهای فناورانه | سازمانی (Corporate Ethics) |

| اسناد UNESCO و EU AI Act | استانداردها و اصول بینالمللی | جهانی (Global Governance) |

این سه سطح در کنار هم اکوسیستمی اخلاقی میسازند که اگر یکی از آنها نادیده گرفته شود، تعادل کل نظام از بین میرود.

اصول بنیادین اخلاق در هوش مصنوعی

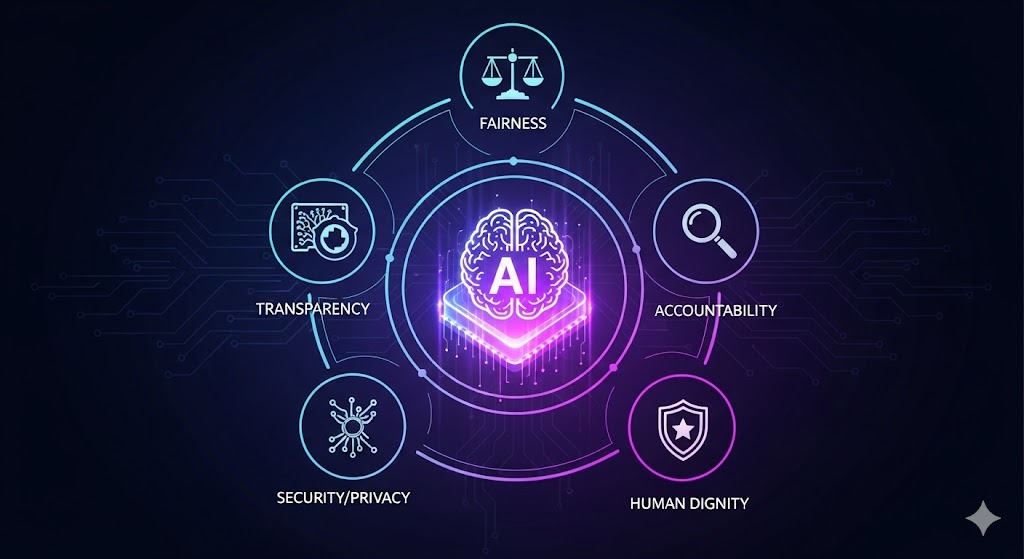

در دهه اخیر، نهادهای بینالمللی بیش از ۱۰۰ سند رسمی درباره اخلاق AI منتشر کردهاند. با وجود تفاوتها، تقریباً همه بر پنج اصل بنیادین تأکید دارند (Jobin et al., 2019):

| نهاد مرجع | توضیح علمی | اصل بنیادین |

|---|---|---|

| OECD, IEEE | جلوگیری از تبعیض و سوگیری دادهها در تصمیمات | عدالت (Fairness) |

| EU, UNESCO | توضیحپذیری تصمیمات الگوریتمی برای کاربران و قانونگذاران | شفافیت (Transparency) |

| EU AI Act | تعیین مسئول انسانی در بروز خطاهای الگوریتمی | پاسخگویی (Accountability) |

| GDPR, NIST | حفاظت از دادههای شخصی و جلوگیری از نشت یا سوءاستفاده | امنیت و حریم خصوصی (Privacy) |

| WHO, UNDP | تضمین منافع انسان در طراحی و استفاده از فناوری | کرامت و رفاه انسانی (Human Dignity & Well-being) |

این اصول هسته اخلاقی هوش مصنوعیاند؛ اما اجرای آنها نیازمند ترجمه به سیاستها و اقدامات واقعی است، نه صرفاً شعارهای شرکتی.

بایدها: آنچه هوش مصنوعی باید رعایت کند

طراحی انسانمحور (Human-centered Design)

هر سامانه هوش مصنوعی باید به گونهای طراحی شود که انسان را در مرکز فرایند نگه دارد. این یعنی تصمیم نهایی در امور حیاتی همچنان باید با انسان باشد. به عنوان مثال، در حوزه سلامت، پزشک باید تصمیم نهایی را بگیرد، نه الگوریتم تشخیص (Amann et al., 2020).

شفافیت و تبیینپذیری (Explainability)

AI باید قابل توضیح باشد. کاربران حق دارند بدانند چرا از وامی محروم شدند یا چرا یک سیستم امنیتی آنها را فرد پرخطر تشخیص داده است (Doshi-Velez & Kim, 2017). شرکتهایی مانند IBM و Google ابزارهای XAI (Explainable AI) را توسعه دادهاند تا این نیاز را برطرف کنند.

نظارت انسانی مستمر (Human Oversight)

هیچ الگوریتمی نباید بدون نظارت انسانی در حوزههای حساس مانند عدالت، امنیت یا پزشکی تصمیم بگیرد. اتحادیه اروپا در قانون AI خود این اصل را بهعنوان الزام قانونی گنجانده است (European Parliament, 2024).

دادههای منصفانه و متنوع

مدلهای AI باید با دادههایی آموزش ببینند که تنوع جغرافیایی، جنسیتی و فرهنگی را بازتاب دهند. دادههای جانبدارانه، سوگیری سیستماتیک تولید میکنند. مثال معروف، سیستم استخدام آمازون است که زنان را بهدلیل دادههای ناعادلانه کنار میگذاشت (Buolamwini & Gebru, 2018).

نبایدها: مرزهایی که نباید شکسته شوند

استفاده از دادههای شخصی بدون رضایت

استفاده از دادههای کاربران بدون آگاهی یا رضایت آنها نقض آشکار حریم خصوصی است و خلاف اصول GDPR و قوانین ملی حفاظت دادهها بهشمار میآید (European Commission, 2020).

دستکاری روانی و تبلیغات سیاسی هدفمند

استفاده از AI برای هدایت افکار عمومی، مانند رسوایی کمبریج آنالیتیکا (Cambridge Analytica) در سال ۲۰۱۸، نمونهای از سوءاستفاده اخلاقی الگوریتمهاست (O’Neil, 2016).

الگوریتمهای تبعیضآمیز

نباید از مدلهایی استفاده شود که بر اساس جنسیت، نژاد یا موقعیت اجتماعی قضاوت میکنند. عدالت الگوریتمی شرط اعتماد عمومی است.

حذف کامل نظارت انسانی

اتکا به الگوریتم بدون حضور قضاوت انسانی، فناوری را از کنترل خارج میکند. انسان باید همیشه «در چرخه» باقی بماند (in the loop).

چارچوبهای بینالمللی اخلاق در AI

اتحادیه اروپا (EU AI Act)

قانون ۲۰۲۴ اتحادیه اروپا نخستین چارچوب جامع حقوقی برای هوش مصنوعی است. این قانون سامانههای AI را در چهار سطح خطر دستهبندی میکند — از «کمخطر» تا «غیرقابلقبول» — و برای هر سطح الزامات اخلاقی مشخصی تعیین میکند (European Parliament, 2024).

OECD Principles (2019)

سازمان همکاری و توسعه اقتصادی پنج اصل کلیدی را معرفی کرد: رشد فراگیر، عدالت، شفافیت، امنیت و پاسخگویی. این اصول پایه بسیاری از مقررات جهانی بعدی شدند.

IEEE Ethically Aligned Design

انجمن IEEE در سال ۲۰۱۹ سندی منتشر کرد که تأکید دارد AI باید با حفظ کرامت انسانی طراحی شود. این سند یکی از پرارجاعترین منابع سیاستگذاران جهانی است (IEEE, 2019).

UNESCO 2021 Recommendation

یونسکو با مشارکت ۱۹۳ کشور، نخستین چارچوب جهانی اخلاق AI را تصویب کرد. این سند بر تنوع فرهنگی، عدالت اجتماعی و دسترسی برابر به فناوری تأکید دارد.

اخلاق سازمانی و مسئولیت شرکتها

هوش مصنوعی، اگرچه محصول پژوهشهای علمی است، اما امروز بیش از هر چیز در اختیار شرکتها و نهادهای اقتصادی است. از غولهایی مانند Google، Meta، Amazon و IBM گرفته تا استارتاپهای هوش مصنوعی مولد، هرکدام بهنوعی سازنده یا بهرهبردار الگوریتمهاییاند که بر رفتار میلیاردها نفر اثر میگذارند. بنابراین پرسش بنیادین این است: چه کسی باید پاسخگوی تصمیمهای اخلاقی ماشینها باشد؟

مطالعه «Whittlestone et al. (2019)» از دانشگاه آکسفورد نشان میدهد که بسیاری از شرکتها «منشور اخلاقی» (Ethical Charter) تدوین کردهاند، اما تنها درصد کمی از آنها این اصول را در چرخه واقعی توسعه و ارزیابی محصولات اعمال میکنند. بهعبارتی، فاصله میان شعار و عمل در حوزه اخلاق سازمانی هنوز زیاد است.

شرکت IBM از نخستین نهادهایی بود که مفهوم «هوش مصنوعی قابل اعتماد» (Trustworthy AI) را معرفی کرد. این شرکت در سال ۲۰۲۳ «هیئت اخلاق هوش مصنوعی» (AI Ethics Board) خود را تشکیل داد که وظیفهاش بررسی تبعات اجتماعی محصولات AI پیش از عرضه است. بهطور مشابه، Microsoft در سند «Responsible AI Standard» خود (2023) پنج محور اصلی را الزامآور کرده است: شفافیت، پاسخگویی، عدالت، امنیت و کنترل انسانی.

در مقابل، نمونههایی نیز وجود دارد که بیتوجهی به اصول اخلاقی، آسیبهای جدی به اعتبار سازمانها وارد کرده است. شرکت Clearview AI در سال ۲۰۲۰ بهدلیل جمعآوری بدون اجازه دادههای چهره از شبکههای اجتماعی با چندین شکایت حقوقی مواجه شد. همین امر باعث شد کشورهای اروپایی مقررات سختگیرانهتری برای استفاده از دادههای زیستی تصویب کنند.

نتیجه: اخلاق سازمانی در هوش مصنوعی باید نهتنها بخشی از روابط عمومی شرکتها، بلکه جزئی از معماری مدیریتی، طراحی محصول و فرایند تصمیمگیری باشد.

نقش دولتها و قانونگذاران

هوش مصنوعی بهسرعت در حال پیشیگرفتن از ظرفیت قانونگذاری سنتی است. دولتها باید میان حمایت از نوآوری و حفاظت از منافع عمومی تعادل برقرار کنند. اتحادیه اروپا با تصویب EU AI Act (2024) گامی بزرگ در این مسیر برداشت. این قانون، سیستمهای AI را بر اساس سطح خطر طبقهبندی میکند:

- خطر غیرقابلقبول (مثلاً نظارت جمعی یا امتیازدهی اجتماعی)

- خطر بالا (پزشکی، حملونقل، استخدام)

- خطر محدود (تبلیغات و تعامل کاربر)

- خطر کم یا صفر (کاربردهای روزمره)

کشورهایی مانند کانادا، ژاپن و استرالیا نیز چارچوبهای مشابهی ایجاد کردهاند. در آمریکا، رویکرد بیشتر «خودتنظیمی صنعتی» است؛ نهادهایی مانند NIST راهنمای استانداردسازی اخلاق AI را تدوین کردهاند.

بااینحال، چالش بزرگ آن است که فناوری مرز نمیشناسد، اما قانون بله. الگوریتمی که در یک کشور ساخته میشود، ممکن است در دهها کشور دیگر تصمیمگیری کند. این وضعیت نیازمند همکاری جهانی است تا از «گردش آزاد تبعیض الگوریتمی» جلوگیری شود.

اخلاق در صنایع

سلامت و پزشکی

کاربرد هوش مصنوعی در سلامت از تشخیص تصویر تا پایش بیماران گسترش یافته است. مطالعه Amann et al. (2020) در The Lancet Digital Health نشان داد که بیشتر مدلهای AI پزشکی فاقد ارزیابی اخلاقیاند. بزرگترین خطر، سوگیری داده است؛ اگر دادههای آموزشی بیشتر از یک منطقه خاص باشند، دقت مدل در مناطق دیگر افت میکند.

در نتیجه، اصل عدالت دادهای در پزشکی حیاتی است. پزشکان باید بدانند الگوریتم چگونه به نتیجه رسیده و بیماران باید از استفاده از AI آگاه باشند.

آموزش

در آموزش، سامانههای AI میتوانند یادگیری را شخصیسازی کنند، اما اگر دادهها ناعادلانه باشند، نابرابری آموزشی را تشدید میکنند. پژوهش Mihaela Vieriu & Petrea (2025) در Education Sciences نشان میدهد که استفاده بیبرنامه از AI در ارزیابی تحصیلی میتواند سوگیری طبقاتی ایجاد کند. اخلاق در این حوزه یعنی شفافیت در معیارها و تضمین فرصت برابر یادگیری.

نظام قضایی

دادگاههای آمریکا از الگوریتمهای «پیشبینی تکرار جرم» (Recidivism Prediction) مانند COMPAS استفاده کردهاند، اما بررسی Angwin et al. (2016) نشان داد که این الگوریتمها علیه متهمان سیاهپوست سوگیری دارند. نتیجه آن است که هیچ سامانهای نباید جایگزین قاضی شود؛ بلکه تنها باید ابزار کمکی باشد.

امنیت و دفاع

بحث استفاده از AI در سلاحهای خودکار کشنده یکی از موضوعات داغ اخلاقی است. سازمان ملل در سال ۲۰۲۳ خواستار ممنوعیت جهانی «رباتهای قاتل» شد. اخلاق در این حوزه بهمعنای حفظ اختیار انسانی بر تصمیمهای مرگوزندگی است.

آینده اخلاق در هوش مصنوعی

با سرعتی که هوش مصنوعی در حال پیشرفت است، روشن است که قوانین و چارچوبهای اخلاقی فعلی نمیتوانند همگام با آن حرکت کنند. تا چند سال پیش، دغدغه اصلی پژوهشگران عدالت دادهای و شفافیت بود؛ اما اکنون با ظهور هوش مصنوعی مولد (Generative AI)، مباحث تازهای مطرح شدهاند: مالکیت اثر هنری، حقوق مؤلف، اطلاعات غلط، و حتی حق انسان برای ناشناختهماندن.

در گزارش سال ۲۰۲۵ مؤسسه Stanford HAI آمده است که ۹۰ درصد از مدلهای هوش مصنوعی در سال گذشته توسط شرکتهای خصوصی توسعه یافتهاند (Stanford HAI, 2025). این یعنی بخش خصوصی عملاً کنترل اصلی را در دست دارد و ضرورت نظارت اخلاقی مستقل بیش از هر زمان احساس میشود.

در همین راستا، دانشگاه MIT پیشنهاد «کمیتههای اخلاق چندذینفعی» را مطرح کرده است که شامل نمایندگان از دانشگاه، صنعت، نهادهای حقوقی و گروههای مدنی باشد. این کمیتهها باید پیش از انتشار فناوری، ارزیابی اخلاقی انجام دهند — مشابه بررسی اخلاقی در پروژههای پزشکی (Amann et al., 2020).

در سطح کلان، آینده اخلاق در AI به سوی سه جهت در حال حرکت است:

- هوش مصنوعی قابل توضیح و قابل حسابرسی (Explainable & Auditable AI):

مدلهایی که مسیر تصمیمگیریشان قابل پیگیری و کنترل است. - هوش مصنوعی همراستا با ارزشهای انسانی (Human-aligned AI):

توسعه الگوریتمهایی که اهدافشان در هماهنگی با ارزشها و فرهنگهای محلی است. - هوش مصنوعی پایدار (Sustainable AI):

توجه به مصرف انرژی و اثرات زیستمحیطی مدلهای بزرگ؛ چرا که آموزش هر مدل زبانی بزرگ میتواند میلیونها کیلوواتساعت انرژی مصرف کند.

این سه روند نشان میدهند که اخلاق در آینده، بخشی از معماری فنی خواهد بود، نه صرفاً ضمیمهای پس از توسعه.

همگرایی فناوری و مسئولیت

اخلاق در هوش مصنوعی دیگر نمیتواند صرفاً مسئولیت توسعهدهندگان باشد. کاربران، سیاستگذاران، و حتی مصرفکنندگان عادی در شکلدادن به رفتار الگوریتمها نقش دارند. برای نمونه، اگر کاربران به اخبار جعلی تولیدشده توسط هوش مصنوعی واکنش نشان دهند و آن را بازنشر نکنند، خود بهنوعی در کنترل اخلاقی فضا سهیماند.

در دهه آینده، پیشبینی میشود که رشتههایی مانند فلسفه فناوری، روانشناسی شناختی و علوم داده بیشتر از همیشه بههم نزدیک شوند. هدف نهایی این است که به جای مهندسی صرفِ «هوش»، نوعی مهندسی اخلاق (Moral Engineering) شکل گیرد؛ حوزهای که مهندسان داده و فیلسوفان در کنار هم سیستمهایی میسازند که تصمیمهایشان بر پایه ارزشهای انسانی باشد (Calo, 2021).

این رویکرد در پژوهشهای دانشگاه آکسفورد به نام Ethics by Design شناخته میشود — یعنی گنجاندن اصول اخلاقی در همان مرحله طراحی، نه پس از بروز مشکل. این مفهوم در حال تبدیل شدن به استانداردی جهانی است و حتی شرکتهای بزرگ فناوری نیز آن را در خطمشیهای خود گنجاندهاند.

مقایسه سطوح اخلاق در هوش مصنوعی

برای درک بهتر ساختار چندلایه اخلاق، میتوان آن را در سه سطح فردی، سازمانی و جهانی تحلیل کرد:

| هدف نهایی | نبایدها | بایدها | بازیگران کلیدی | سطح تحلیل |

|---|---|---|---|---|

| رشد اخلاق حرفهای | استفاده از داده بدون رضایت، ایجاد سوگیری در مدل | رعایت حریم خصوصی، افزایش سواد دادهای، خودآزمایی اخلاقی | مهندسان داده، پژوهشگران، کاربران | فردی |

| اعتماد عمومی به فناوری | اولویت دادن به سود بر ارزش انسانی، پنهانکاری در عملکرد مدلها | ممیزی منظم الگوریتمها، شفافیت در تصمیمات، هیئت اخلاق داخلی | شرکتها و مؤسسات فناورانه | سازمانی |

| عدالت فناورانه در مقیاس جهانی | استانداردسازی بدون توجه به تفاوتهای فرهنگی | همکاری در تنظیم مقررات، احترام به تنوع فرهنگی، اشتراکگذاری تجربیات | دولتها، نهادهای بینالمللی | جهانی |

این جدول نشان میدهد که اخلاق در AI فقط یک موضوع فلسفی نیست، بلکه شبکهای از مسئولیتهای متقاطع است. هیچ سطحی بدون دیگری پایدار نمیماند.

ضرورت آموزش اخلاقی

برای تحقق اخلاق در AI، تنها قانون کافی نیست. باید نسل جدیدی از متخصصان پرورش یابند که علاوه بر ریاضیات و برنامهنویسی، فلسفه، حقوق و جامعهشناسی را نیز درک کنند. بسیاری از دانشگاههای جهان از جمله MIT، Harvard و آکسفورد، اکنون واحدهای «اخلاق داده و هوش مصنوعی» را در برنامههای درسی گنجاندهاند.

در ایران نیز برخی دانشگاهها مانند صنعتی شریف و تهران در حال طراحی دورههای میانرشتهای هوش مصنوعی و فلسفه فناوری هستند. آموزش بینرشتهای میتواند پایهگذار فرهنگ توسعه مسئولانه باشد.

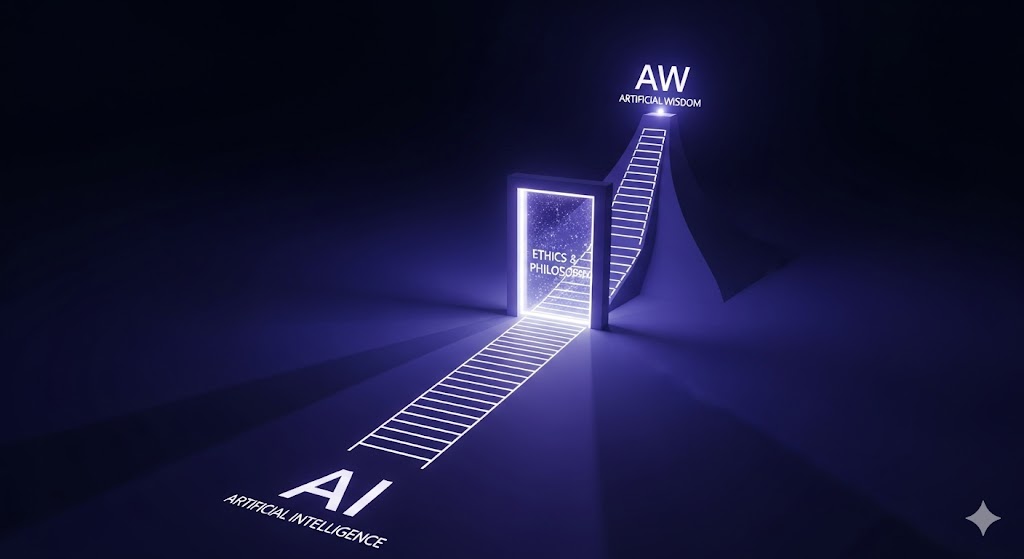

نگاهی آیندهپژوهانه: از هوش مصنوعی به خرد مصنوعی

پژوهشگران فلسفه فناوری پیشنهاد کردهاند که باید از مفهوم Artificial Intelligence به سمت Artificial Wisdom (خِرَد مصنوعی) حرکت کنیم. در این دیدگاه، هدف نهایی از توسعه ماشینهای هوشمند، نه صرفاً افزایش قدرت محاسبه، بلکه ارتقای درک اخلاقی و ارزشی است.

به بیان دیگر، فناوری آینده باید تصمیم بگیرد که «چه کاری درست است»، نه فقط «چه کاری ممکن است».

پیشرفت واقعی زمانی است که الگوریتمها بتوانند پیامدهای انسانی تصمیمهایشان را بسنجند. این ایده هنوز در مرحله نظری است، اما بنیادهایی مانند Oxford AI Ethics Lab در حال بررسی امکان پیادهسازی آناند.

نتیجهگیری

هوش مصنوعی دیگر تنها فناوری نیست؛ نیرویی است که شکل تصمیمگیری، عدالت اجتماعی و حتی تعریف ما از انسان بودن را تغییر میدهد. اگر این فناوری بر پایه اصول اخلاقی چون عدالت، شفافیت، پاسخگویی و کرامت انسانی هدایت نشود، میتواند به ابزاری برای تبعیض و کنترل تبدیل شود.

بایدها و نبایدهای اخلاقی در هوش مصنوعی مسیر تعادل میان نوآوری و انسانیت را مشخص میکنند. رعایت اصولی مانند عدالت دادهای، شفافیت الگوریتمی و حفظ حریم خصوصی تضمین میکند که فناوری در خدمت بشر باقی بماند. در مقابل، تصمیمگیری خودکار در حوزههای حیاتی یا استفاده از دادههای بدون رضایت، مصداقهایی از نادیدهگرفتن اخلاقاند که مشروعیت علمی و اجتماعی فناوری را تهدید میکنند.

آینده هوش مصنوعی به میزان توان ما در ادغام اخلاق با فناوری بستگی دارد. توسعه خرد فناورانه بدون وجدان انسانی تنها قدرت میآفریند، نه پیشرفت. هوش مصنوعی زمانی به بلوغ میرسد که نهفقط هوشمند، بلکه منصف، شفاف و مسئول باشد.

منابع

- Amann, J., Blasimme, A., Vayena, E., Frey, D., & Madai, V. I. (2020). Explainability for artificial intelligence in healthcare: A multidisciplinary perspective. BMC Medical Informatics and Decision Making, 20(310), 1–9. https://doi.org/10.1186/s12911-020-01332-6

- Angwin, J., Larson, J., Mattu, S., & Kirchner, L. (2016). Machine bias: There’s software used across the country to predict future criminals. ProPublica. https://www.propublica.org/article/machine-bias-risk-assessments-in-criminal-sentencing

- Borenstein, J., & Arkin, R. (2017). Robotic nudges: The ethics of engineering a more socially just human being. Science and Engineering Ethics, 23(4), 989–1005. https://doi.org/10.1007/s11948-016-9821-1

- Buolamwini, J., & Gebru, T. (2018). Gender shades: Intersectional accuracy disparities in commercial gender classification. Proceedings of Machine Learning Research, 81, 1–15.

- Calo, R. (2021). Artificial intelligence policy: A primer and roadmap. University of California Law Review, 59(2), 12–45.

- Doshi-Velez, F., & Kim, B. (2017). Towards a rigorous science of interpretable machine learning. arXiv preprint arXiv:1702.08608.

- Floridi, L., Cowls, J., Beltrametti, M., Chatila, R., Chazerand, P., Dignum, V., … & Vayena, E. (2018). AI4People—An ethical framework for a good AI society: Opportunities, risks, principles, and recommendations. Minds and Machines, 28(4), 689–707. https://doi.org/10.1007/s11023-018-9482-5

- IBM. (2023). Principles for Trust and Transparency in Artificial Intelligence. IBM Research White Paper. https://research.ibm.com

- Jobin, A., Ienca, M., & Vayena, E. (2019). The global landscape of AI ethics guidelines. Nature Machine Intelligence, 1(9), 389–399. https://doi.org/10.1038/s42256-019-0088-2

- Mihaela Vieriu, A., & Petrea, G. (2025). The impact of artificial intelligence on students’ academic development. Education Sciences, 15(3), 343. https://doi.org/10.3390/educsci15030343

- O’Neil, C. (2016). Weapons of math destruction: How big data increases inequality and threatens democracy. Crown Publishing.

- Stanford HAI. (2025). 2025 AI Index Report. Stanford University. https://hai.stanford.edu

- Whittlestone, J., Nyrup, R., Alexandrova, A., Dihal, K., & Cave, S. (2019). The role and limits of principles in AI ethics: Towards a focus on tensions. Proceedings of the AAAI/ACM Conference on AI, Ethics, and Society, 195–200. https://doi.org/10.1145/3306618.3314289

- UNESCO. (2021). Recommendation on the Ethics of Artificial Intelligence. UNESCO Publishing. https://unesdoc.unesco.org