مقدمه

هوش مصنوعی (Artificial Intelligence – AI) فراتر از یک فناوری، تجسم آرزوی چند هزار سالهی بشر برای ساختن موجودی متفکر و هوشمند است. از اساطیر یونان باستان (مانند تالوس) تا پیشگامان قرن بیستم، تمایل به ایجاد هوش مصنوعی پیوسته در بطن توسعهی فکری بشر حضور داشته است. با این حال، مطالعهی تاریخ AI نه فقط واکاوی گذشته، بلکه درک چرخههای علمی، فراز و نشیبهای پژوهشی، و دلایل شکستها و پیروزیهای متوالی است که مسیر تحول کنونی را رقم زده است. این تاریخچه، نقشهای است که نشان میدهد چگونه نوآوریهایی مانند شبکههای عصبی (که در دههی ۱۹۵۰ شکست خوردند) توانستند در قرن بیست و یکم به قدرت مسلط تبدیل شوند.

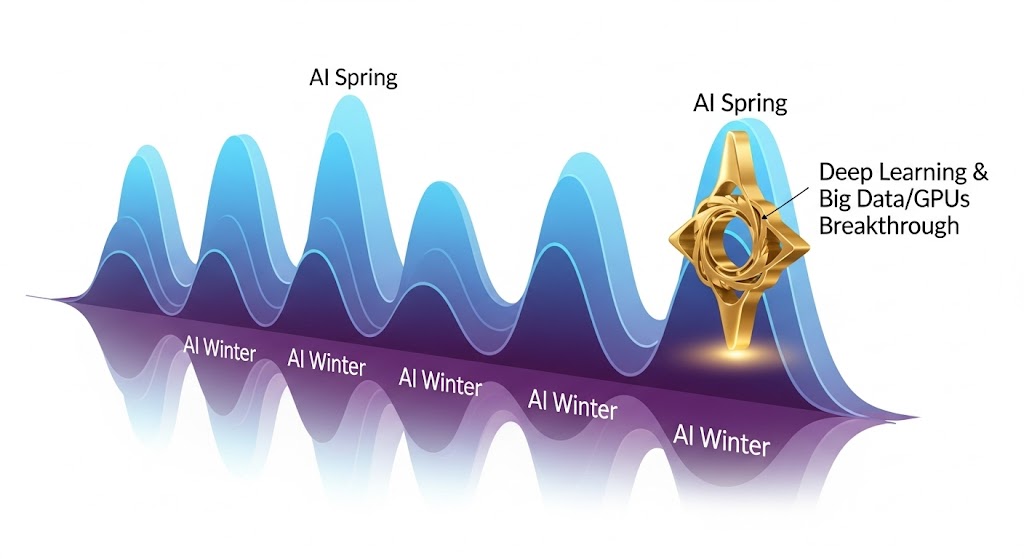

چرا مطالعهی تاریخچه هوش مصنوعی این قدر مهم است؟ پاسخ در درک ماهیت چرخهای (Cyclical Nature) این رشته نهفته است. تاریخ AI با دو «زمستان هوش مصنوعی» (AI Winters) مشخص شده است که در پی انتظارات بیش از حد و عدم تحقق وعدههای بزرگ، بودجه و حمایت عمومی کاهش یافت. متخصصان امروز با مطالعهی این دورهها میآموزند که چگونه میتوان از تکرار اشتباهات گذشته (مانند وابستگی بیش از حد به یک پارادایم واحد یا ارائهی وعدههای غیرواقعی) پرهیز کرد و توسعهی AI را بر مبنای اصول پایدار و واقعبینانه بنا نهاد (Russell & Norvig, 2021). درک این سیر تحول به ما کمک میکند تا انقلاب کنونی یادگیری عمیق (Deep Learning – DL) را نه به عنوان یک معجزهی ناگهانی، بلکه به عنوان اوج همگرایی چندین دههی پیشرفت نظری و سختافزاری ببینیم.

این مقاله با ساختاری علمی و تحلیلی، خوانندگان دانشگاهی را در سفری تاریخی از مبانی فلسفی و ریاضی AI تا ظهور مدلهای زبان بزرگ (LLMs) و مدلهای بنیادی همراه میسازد تا نه تنها گذشته را درک کنیم، بلکه آیندهی پژوهش را نیز بر اساس این میراث بنا نهیم.

تعریف علمی و تمایز مفهومی

تعریف علمی حوزه تاریخ هوش مصنوعی

تاریخ هوش مصنوعی را میتوان به عنوان مطالعهی علمی و انتقادی از تحول پارادایمهای محاسباتی، فلسفی و مهندسی تعریف کرد که هدف آنها تقلید یا بازتولید هوش انسانی در ماشینها بوده است. تمرکز اصلی این حوزه، بررسی چهار رویکرد اصلی است که جان مککارتی (John McCarthy) و آلن نیوول (Allen Newell) پایهریزی کردند (Turing, 1950; Russell & Norvig, 2021):

- سیستمهایی که مانند انسان فکر میکنند: رویکرد علوم شناختی.

- سیستمهایی که منطقی فکر میکنند: رویکرد قوانین منطقی و استدلال.

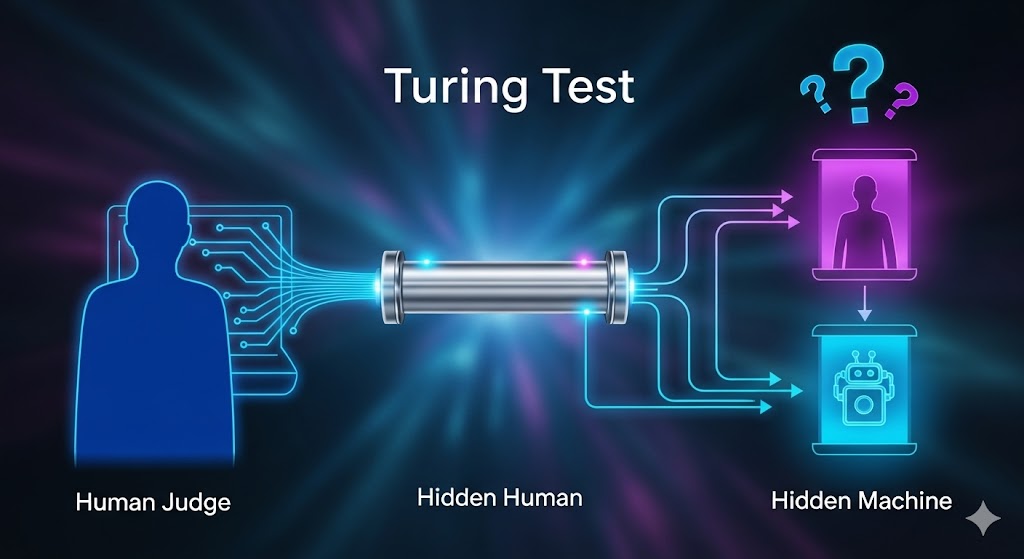

- سیستمهایی که مانند انسان عمل میکنند: رویکرد آزمون تورینگ.

- سیستمهایی که منطقی عمل میکنند: رویکرد عامل منطقی که دیدگاه غالب مهندسی امروز است.

تاریخ AI عمدتاً بر بررسی چگونگی جابجایی تمرکز از رویکردهای ۲ و ۳ (سیستمهای مبتنی بر دانش/نمادین) به رویکرد ۴ (سیستمهای مبتنی بر داده/یادگیری) تمرکز دارد.

تمایز مفهومی: از نمادینگرایی تا اتصالگرایی

تاریخ AI با دو رویکرد متضاد شناخته میشود که در مقاطع مختلف تاریخ بر یکدیگر غالب بودهاند:

| هستهی اصلی / تفاوت | دورهی اوج | پارادایم |

|---|---|---|

| متکی بر منطق، قواعد صریح، و دستکاری نمادها برای حل مسئله (مثلاً سیستمهای خبره). هدف، تقلید از فرآیند استدلال انسانی. | دهههای ۱۹۵۰ تا اواسط ۱۹۸۰ | نمادینگرایی (Symbolicism) |

| متکی بر یادگیری از دادهها و استفاده از شبکههای عصبی که در آن دانش به صورت توزیعشده در اتصالات ذخیره میشود. هدف، تقلید از ساختار مغز. | اواخر دههی ۱۹۸۰ و دههی ۲۰۰۰ به بعد | اتصالگرایی (Connectionism) |

تمایز کلیدی: دوران اول AI (قبل از ۱۹۸۰) تحت تسلط نمادینگرایی بود که شکست آن عمدتاً به دلیل عدم توانایی در مدیریت ابهام، دانش عمومی (Common Sense) و حجم عظیم دادههای دنیای واقعی بود. انقلاب اخیر AI (پس از ۲۰۱۰) به لطف پیروزی اتصالگرایی و یادگیری عمیق، که قابلیت یادگیری خودکار ویژگیها را دارد، شکل گرفت (LeCun et al., 2015).

ساز و کار و نحوه عملکرد تحول

تاریخ AI با یک سازوکار چرخشی کلیدی پیش رفته است: چرخهی انتظارات و واقعیتها که به دورههای بهار AI و زمستان AI منجر شده است.

سازوکار چرخهی تاریخی و زمستان AI

تحولات در AI معمولاً شامل یک چرخهی سهمرحلهای بوده است:

- وعدهی بزرگ و سرمایهگذاری: یک پیشرفت تکنیکی جدید (مانند Perceptron در ۱۹۵۰، یا Expert Systems در ۱۹۷۰) ایجاد میشود. پژوهشگران قول میدهند که در عرض چند سال، ماشینهای هوشمند عمومی ساخته خواهند شد.

- شکست در مقیاسپذیری: مدلهای اولیه به خوبی در محیطهای کنترلشده و کوچک (Micro-Worlds) عمل میکنند، اما در مواجهه با پیچیدگی، ابهام و حجم دادههای دنیای واقعی شکست میخورند.

- زمستان AI :در پی شکست مقیاسپذیری و قطع سرمایهگذاریهای دولتی و خصوصی (مانند بحران Lisp Machines در اواخر دهه ۱۹۸۰)، پژوهش به صورت پنهانی و با بودجههای محدود در دانشگاهها و آزمایشگاههای کوچک ادامه مییابد تا زمانی که پارادایم جدیدی ظهور کند (McCorduck, 2004).

مثال: اولین زمستان AI (اواسط دههی ۱۹۷۰) زمانی رخ داد که گزارش لایتهیل (Lighthill Report) در بریتانیا و قطع حمایتهای مالی DARPA در آمریکا، آشکار کرد که وعدههای هوش مصنوعی نمادین (مانند ترجمه ماشینی) برای دههها دور از دسترس هستند.

مکانیسمهای اصلی برای عبور از بحران ها

مکانیسمهایی که به انقلاب کنونی DL منجر شدند، مستقیماً به حل مشکلات تاریخی باز میگردند:

- انتقال از منطق به احتمال: در دههی ۱۹۹۰، ML بر پایه آمار و احتمالات (مانند شبکههای بیزی) پایهگذاری شد، زیرا مدلهای مبتنی بر منطق در مدیریت عدم قطعیت دنیای واقعی شکست خورده بودند.

- ظهور سختافزار موازی: شکست شبکههای عصبی اولیه )مانند Perceptron) به دلیل نبود قدرت محاسباتی کافی برای آموزش شبکههای چندلایه بود. در قرن بیست و یکم، GPUها (Graphics Processing Units) که برای بازیهای ویدئویی طراحی شده بودند، با قابلیت موازیسازی خود، این مانع را از میان برداشتند (LeCun et al., 2015).

- Big Data و منابع باز: در دهههای گذشته، کمبود دادههای برچسبدار مانع اصلی بود. ظهور اینترنت، شبکههای اجتماعی و پروژههای جمعسپاری(مانند ImageNet) این مشکل را حل کرد و سوخت مورد نیاز برای آموزش شبکههای عمیق را تأمین کرد.

انواع، مدلها و زیرشاخههای کلیدی در گذر تاریخ

تاریخ AI را میتوان بر اساس پارادایمها و مدلهای حاکم در آن دوره دستهبندی کرد.

دوران طلایی و هوش مصنوعی نمادین (۱۹۵۰-۱۹۷۰)

- نقطه عطف: کنفرانس دارتماوث در ۱۹۵۶ که به عنوان زادگاه رسمی AI شناخته میشود (McCarthy, Minsky, Shannon).

- مدل غالب: منطق نمادین و جستجوی اکتشافی. هدف، شبیهسازی مراحل استدلال انسانی با استفاده از نمادها و قواعد صریح بود.

- مثال Logic Theorist: و General Problem Solver (GPS) که توانستند اثباتهای ریاضی و حل پازلهای ساده را انجام دهند (Newell, Simon, 1963).

سیستمهای خبره و بازگشت اتصالگرایی (۱۹۷۰-۱۹۹۰)

- مدل غالب: سیستمهای خبره. این سیستمها از پایگاه دادههای دانش و موتور استنتاج (Inference Engines) برای تصمیمگیری در حوزههای محدود استفاده میکردند. مثال: MYCIN در تشخیص بیماریهای خونی.

- بازگشت شبکههای عصبی: در دههی ۱۹۸۰، با ابداع الگوریتم انتشار به عقب (Backpropagation)، شبکههای عصبی چندلایه مجدداً مورد توجه قرار گرفتند و قابلیت مدلسازی غیرخطی را فراهم ساختند (Rumelhart et al., 1986).

- چالش: شکنندگی سیستمهای خبره در خارج از دامنه تخصصیشان و نیاز به نگهداری پرهزینهی پایگاههای دانش.

عصر یادگیری ماشین آماری (Statistical ML) (۱۹۹۰-۲۰۱۰)

- مدل غالب: انتقال تمرکز به مدلهای مبتنی بر آمار و احتمال. پژوهشگران یاد گرفتند که عدم قطعیت را به جای منطق صریح، با احتمالات مدلسازی کنند.

- الگوریتمهای کلیدی: ماشینهای بردار پشتیبان (Support Vector Machines – SVM) با استفاده از ترفند هسته (Kernel Trick)، شبکههای بیزی (Bayesian Networks)، و درختهای تصمیم (Decision Trees) (Mitchell, 1997).

- اهمیت: این دوره، عصر ML کلاسیک بود که قابلیت تعمیم (Generalization) مدلها را نسبت به دوران نمادین بهبود بخشید.

انقلاب یادگیری عمیق (Deep Learning Revolution) (۲۰۱۰-امروز)

- مدل غالب: شبکههای عصبی عمیق (Deep Neural Networks)، شامل CNN، RNN، LSTM و Transformers.

- نقاط عطف: پیروزی AlexNet در چالش ImageNet (2012) که برتری DL در بینایی ماشین را ثابت کرد، و معرفی معماری ترانسفورمر در سال ۲۰۱۷ که انقلابی در پردازش زبان طبیعی (NLP) ایجاد کرد (Vaswani et al., 2017).

- نتیجه: DL با حل مشکل مهندسی ویژگی دستی، و استفاده از سختافزارهای موازی و دادههای عظیم، منجر به بهار AI کنونی شد.

کاربردهای واقعی در گذر تاریخ

تاریخ هوش مصنوعی مملو از نقاط عطفی است که توانایی ماشین در شبیهسازی هوش را در دورههای مختلف به نمایش گذاشته است.

ELIZA (دههی ۱۹۶۰):

- کاربرد: اولین چتبات یا برنامهی گفتگو که توسط جوزف ویزنباوم (Joseph Weizenbaum) در MIT ساخته شد.

- مثال: ELIZA با استفاده از تطابق الگوهای ساده و بازتاب جملات، گفتگوهای شبیه به یک رواندرمانگر را شبیهسازی میکرد و نشان داد که چگونه میتوان تنها با تکیه بر دستورالعملهای ساده، احساس هوشمندی را در کاربر ایجاد کرد (Weizenbaum, 1966).

Deep Blue (۱۹۹۷):

- کاربرد: اولین کامپیوتر که قهرمان شطرنج جهان، گری کاسپاروف، را در یک مسابقهی رسمی شکست داد.

- مثال: Deep Blue شرکت IBM از یک الگوریتم (Tree Search) و یک سختافزار بسیار قدرتمند (بروت-فورس) برای ارزیابی ۲۰۰ میلیون وضعیت شطرنج در ثانیه استفاده میکرد و نشانگر اوج توانمندی رویکرد جستجوی سنتی AI بود.

AlphaGo (۲۰۱۶):

- کاربرد: اولین سیستم AI که قهرمان جهان در بازی پیچیدهی Go را شکست داد.

- مثال: DeepMind با توسعهی AlphaGo، نشان داد که AI با ترکیب یادگیری تقویتی و جستجوی درخت مونت کارلو (Monte Carlo Tree Search – MCTS) میتواند وظایفی را که قبلاً به دلیل فضای جستجوی عظیم غیرممکن به نظر میرسید، انجام دهد. این نقطه عطفی در پیروزی پارادایم یادگیری بر پارادایم جستجوی سنتی بود (Silver et al., 2016).

BERT و ترانسفورمرها (۲۰۱۸):

- کاربرد: پیشرفت عظیم در درک بافت و مفهوم در پردازش زبان طبیعی.

- مثال: معرفی مدل BERT توسط Google AI، استفاده از معماری ترانسفورمر را به عنوان استاندارد صنعتی تثبیت کرد و امکان درک دوجهته (Bidirectional) متن را فراهم ساخت که منجر به افزایش چشمگیر دقت در وظایف NLP شد (Devlin et al., 2019).

مزایا، محدودیتها و چالشها در طول تاریخ

بررسی تاریخی نشان میدهد که پیشرفت AI از طریق غلبه بر محدودیتهای پارادایمهای پیشین و پذیرش چالشهای جدید حاصل شده است.

مزایای تاریخی: دستاوردهای کلیدی هر دوران

- مزیت دوران نمادین: شفافیت و قابلیت توضیح بالا. سیستمهای خبره میتوانستند فرآیند استدلال خود را به روشنی برای متخصصان توضیح دهند (Adadi & Berrada, 2018).

- مزیت دوران ML آماری: توانایی مدیریت عدم قطعیت و تعمیمپذیری به دادههای ندیده شده، که یک نقطهی ضعف بزرگ برای سیستمهای مبتنی بر قانون بود.

- مزیت دوران DL: استخراج خودکار ویژگی از دادههای خام، که نیاز به مهندسی ویژگی پرهزینه و مبتنی بر تخصص انسانی را از بین برد.

محدودیتهای تاریخی و چالشهای حل نشده

- مشکل مقیاسپذیری: محدودیت اصلی سیستمهای نمادین و Expert Systems، ناتوانی در کار با صدها هزار قانون یا میلیونها مورد اطلاعات دنیای واقعی بود. این سیستمها به دلیل سختی مهندسی دانش در دههی ۱۹۸۰ شکست خوردند.

- مشکل دانش عمومی: AI در طول تاریخ در کسب و استفاده از دانشی که انسانها به صورت ضمنی دارند، شکست خورده است. برنامهنویسی هر واقعیت و استثنای آن از نظر فنی غیرممکن بود. این چالش هنوز هم در LLMs، به شکل توهم ، خود را نشان میدهد (Bender et al., 2021).

- چالش سوگیری و اخلاق: در گذشته، سوگیریهای الگوریتمی عمدتاً به عنوان مشکلات فنی در نظر گرفته میشد. با این حال، در عصر DL، این چالش تبدیل به یک چالش اخلاقی و اجتماعی شده است، زیرا سوگیریهای موجود در دادههای آموزشی به طور سیستماتیک در مدلهایی که بر زندگی افراد تأثیر میگذارند (مانند استخدام یا عدالت کیفری) تکرار میشوند (Mehrabi et al., 2021).

آینده و مسیر توسعه

تاریخ AI نشان میدهد که موفقیت نهایی در گرو ترکیب نقاط قوت پارادایمهای مختلف و حل چالشهای حل نشده است. مسیر توسعهی آیندهی AI به شدت توسط درسهای گذشته شکل میگیرد.

همگرایی AI نمادین و اتصالگرایی

آیندهی پژوهشی AI به سمت همگرایی هوش مصنوعی نمادین (برای استدلال، برنامهریزی و قابلیت توضیح) و هوش مصنوعی اتصالگرایی (برای ادراک و یادگیری از داده) حرکت میکند. هوش مصنوعی عصبی-نمادین (Neuro-Symbolic AI) به دنبال ایجاد مدلهایی است که بتوانند درک عمیق از دادههای خام را با استدلال منطقی و ساختاریافتهی مدلهای سنتی ترکیب کنند تا مشکل جعبه سیاه (Black-Box Problem)

از پیشبینیکننده به عملکننده: عاملهای هوشمند

پس از دههها تمرکز بر ساخت مدلهای پیشبینیکننده (مانند طبقهبندی و رگرسیون)، پژوهشگران به سمت ساخت عاملهای هوشمند (AI Agents) که میتوانند توالی اقدامات پیچیده را برنامهریزی و اجرا کنند، حرکت کردهاند. این عاملها (مانند آنچه در DeepMind و Berkeley BAIR توسعه مییابند) از تاریخ یادگیری تقویتی (RL) و سیستمهای برنامهریزی نمادین الهام میگیرند تا بتوانند در محیطهای پویا و بدون نظارت انسانی، به اهداف بلندمدت دست یابند (Lilian Weng Blog, 2023).

حکمرانی و AI اخلاقی

درس اصلی تاریخ AI، بهویژه در دوران زمستانها، این است که اعتماد عمومی و حمایت دولتی حیاتی است. روندهای پژوهشی امروز به شدت بر توسعهی هوش مصنوعی اخلاقمدار (Ethical AI) و قابل توضیح (XAI) متمرکز است. پژوهش در حوزهی XAI (که ریشههای آن به شفافیت سیستمهای خبره باز میگردد) به دنبال ابداع روشهایی است تا مدلهای پیچیدهی DL بتوانند فرآیند تصمیمگیری خود را به زبان ساده برای انسانها توضیح دهند، که این امر برای کاربرد در حوزههای حیاتی مانند سلامت و امور مالی ضروری است (Nature Machine Intelligence, 2020).

نتیجهگیری

تاریخ هوش مصنوعی بیش از آن که داستانی از پیروزیهای خطی باشد، روایتی از انعطافپذیری علمی و چرخههای بازسازی پارادایم است. هر شکست (مانند زمستانهای AI) نه یک پایان، بلکه یک فرصت برای تغییر جهت و ظهور ابزارهای قدرتمندتر (مانند ظهور ML آماری یا DL) بوده است. انقلاب کنونی یادگیری عمیق، نتیجهی همگرایی موفقیتآمیز پیشرفتهای نظری دههی ۱۹۸۰ با منابع محاسباتی و دادههای قرن بیست و یکم است.

با نگاهی به این نقشه راه تاریخی، مشخص میشود که آیندهی AI در گرو حل چالشهای دیرینهای چون دانش عمومی و سوگیریهای الگوریتمی است. پژوهشگران آینده باید در کنار تسلط بر آخرین پیشرفتها (مانند مدلهای بنیادی)، درسی را که تاریخ به ما آموخته، به کار بندند: توسعهی AI باید با مسئولیت، شفافیت و با درک عمیق از تأثیرات اجتماعی همراه باشد. تنها با یادگیری از گذشته، میتوانیم ماشینی بسازیم که نه تنها هوشمند باشد، بلکه منطقی، اخلاقی و در خدمت منافع عمومی عمل کند.

منابع

• dadi, A., & Berrada, M. (2018). Peeking inside the black-box: a survey on Explainable Artificial Intelligence (XAI). IEEE Access, 6, 52138-52160.

• Bender, E. M., Gebru, T., McMillan-Major, A., & Shmitchell, S. (2021). On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency (FAccT).

• Devlin, J., Chang, M. W., Lee, K., & Toutanova, K. (2019). BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding. Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologi1es, 1, 4171-4186.

• LeCun, Y., Bengio, Y., & Hinton, G. (2015). Deep learning. Nature, 521(7553), 436-444.

• Lilian Weng Blog. (2023). LLM-Powered Autonomous Agents. (Referencing the current trends informed by historical planning systems).

• McCorduck, P. (2004). Machines Who Think: A Biographical History of the Artificial Intelligence. A. K. Peters.

• Mehrabi, N., et al. (2021). A Survey on Bias and Fairness in Machine Learning. ACM Computing Surveys (CSUR), 54(3), 1-35.

• Mitchell, T. M. (1997). Machine Learning. McGraw-Hill.

• Russell, S., & Norvig, P. (2021). Artificial Intelligence: A Modern Approach (4th ed.). Pearson.

• Rumelhart, D. E., Hinton, G. E., & Williams, R. J. (1986). Learning representations by back-propagating errors. Nature, 323(6088), 533-536.

• Silver, D., Huang, A., Maddison, C. J., Guez, A., Sifre, L., Van Den Driessche, G., … & Hassabis, D. (2016). Mastering the game of Go with deep neural networks and tree search. Nature, 529(7587), 484-489.

• Turing, A. M. (1950). Computing machinery and intelligence. Mind, 59(236), 433-460.

• Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., Kaiser, Ł., & Polosukhin, I. (2017). Attention Is All You Need. Advances in Neural Information Processing Systems (NeurIPS).

• Weizenbaum, J. (1966). ELIZA—A computer program for the study of natural language communication between man and machine. Communications of the ACM, 9(1), 36-45.